Prinzipiell kann die Spracherkennung und -steuerung des Fraunhofer IDMT an jeden noch so individuellen Einsatz angepasst werden. © Fraunhofer IDMT

Prinzipiell kann die Spracherkennung und -steuerung des Fraunhofer IDMT an jeden noch so individuellen Einsatz angepasst werden. © Fraunhofer IDMT

Warum Sprachsteuerung im Fertigungskontext sinnvoll ist

Gesprochene Anweisungen üben schon seit Langem einen gewissen Reiz aus, nun sollen diese nach dem Consumer-Bereich auch in der Industrie Einzug halten. Also Alexa und Co. in der Fabrik? Mitnichten, vielmehr geht es darum, mit dem Automationssystem in Dialog zu treten, wie die Hersteller betonen.

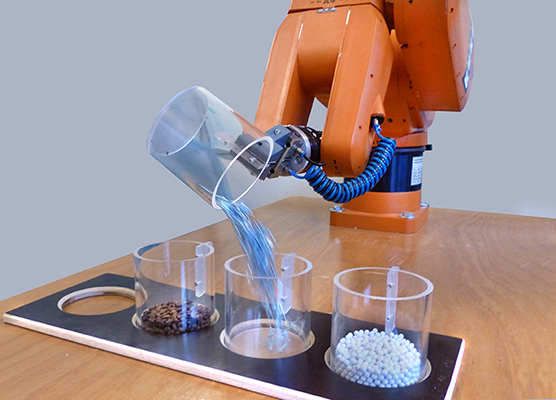

Bitte fülle drei Kilogramm Sechskantschrauben ab und bringe sie zur Verpackungsabteilung“ – eine Aufforderung, die künftig kein Logistikmitarbeiter mehr bekommen soll, sondern vielmehr ein sprachgesteuerter Roboter. Und dank der integrierten akustischen Ereigniserkennung kann der Roboter auch unterscheiden, ob die richtige Sorte Schrauben in den Behälter eingefüllt wird.

Die Mensch-Maschine-Interaktion per Sprachkommando soll ein wichtiger Faktor werden. Interessant für den Einsatz im Produktionskontext sei dabei, ob die Spracherkennung auch in lauten Umgebungen und bei einem größeren Abstand zwischen Sprecher und der zu steuernden Maschine funktioniert. Am Beispiel einer Industrieroboterplattform, wie sie in automatisierten Fertigungsumgebungen eingesetzt wird, zeigten die Entwickler des Fraunhofer-Instituts für Digitale Medientechnologie IDMT schon vor Längerem, wie gut Erkennersysteme Sprache und andere Laute differenziert unterscheiden und Befehle umsetzen können.

Robuste Spracherkennung auch unter schwierigen Bedingungen

Die robuste Erkennung der Spracheingabe basiert auf dem aktuellen wissenschaftlichen Stand psychoakustischer und -physikalischer Grundlagen. Zusätzlich optimiert wird die Erkennungsleistung durch die Berücksichtigung der jeweiligen akustischen Umgebungsbedingungen wie Störgeräusch oder Nachhall. Wenn das Vokabular an die Anforderungen des Einsatzgebiets angepasst wird, erhöht sich die Erkennungsgenauigkeit der Befehle. „Prinzipiell kann unsere Sprachsteuerung an jeden noch so individuellen Einsatz angepasst werden – von der einfachen Befehlssteuerung mit wenigen Worten bis hin zu einem komplexen dialogbasierten Robotersystem“, erklärt Entwickler Stefan Goetze. Die intelligenten Erkennungsalgorithmen lassen sich aber nicht nur zur Detektion von und zur Ansteuerung durch Sprache einsetzen, sondern auch für die akustische Prozessüberwachung in der Industrie. So könnten Abfüllvorgänge überwacht oder Produkte auf Basis ihrer Klangeigenschaften eindeutig zugeordnet werden, wie der Entwickler betont.

Sprachgesteuerte Sensorenabfrage

Im Rahmen der heurigen Hannover Messe präsentierte die in-integrierte informationssysteme GmbH die Integration von Sprachsteuerung und Sprachausgabe in die IoT-Plattform sphinx open online. Damit würden die Abfrage von Sensoren und die Ansteuerung von Aktoren in Industrie-4.0-Umgebungen via Sprache zur Realität, verspricht das Unternehmen. Dies sei wiederum die Basis für neue Interaktionsmöglichkeiten und Hands-free-Anwendungen. Ein gemeinsam mit der Technischen Hochschule Mittelhessen (THM) entwickelter Anwendungsfall verdeutlichte dabei, wie die durchgängige horizontale Vernetzung (vom Kundenauftrag bis zum Service) und die vertikale Vernetzung (vom Sensor über eine IoT-Plattform und das MES bis zum Leitstand) funktionieren können.

Die IoT-Plattform könne Real- und Businessdaten aus verschiedenen Quellen, Anlagen und Systemen zusammenführen, intelligent verarbeiten und Systeme aktiv beeinflussen. Über vernetzte digitale Services sei es möglich, mit sphinx open online verbundene Aktoren anzusteuern sowie Sensorwerte oder Kenngrößen per Sprache abzufragen. „Die mit unserer IoT-Plattform kombinierbare Sprachsteuerung ist ein prädestiniertes Beispiel dafür, wie sich künstliche Intelligenz und Machine-Learning-Verfahren mit sphinx open online verbinden lassen, um zukunftsfähige Lösungen zu schaffen“, erklärt Siegfried Wagner, Geschäftsführer der in-integrierte informationssysteme GmbH.

Auf Basis eines Digital Twins könne sphinx open online ein reales Abbild von Produktionssystemen unter Berücksichtigung aller komplexen Rahmenbedingungen erzeugen. Damit seien auch die Auswertung von Vergangenheitsdaten und die Nutzung von Prognosen möglich. So könnten frühzeitig negative Veränderungen in der Produktionskette erkannt, rechtzeitig Informationen bereitgestellt und automatisiertes Eingreifen ermöglicht werden. „Die Sprachsteuerung sowie weitere Möglichkeiten, die unsere IoT-Plattform rund um digitale Produktionsprozesse, das Energiemanagement und weitere Anwendungsbereiche bietet, stießen bei KMU gleichermaßen wie bei Global Playern auf großes Interesse. Wir konnten sowohl Endkunden als auch Serviceanbieter, die ihre Dienste einfach an unsere Plattform anbinden können, überzeugen“, unterstreicht Wagner.

Automatisierungssystem mit menschlichen Zügen

Beckhoff setzt ebenfalls auf Sprachsteuerung und präsentierte unlängst ein Automatisierungssystem, welches Intelligenz, Sensorik, Bewegungssteuerung und Sehvermögen perfekt aufeinander abgestimmt in sich vereint und mit TwinCAT Speech nun auch das Hören und das Sprechen lernt. Dadurch funktioniere das Automatisierungssystem so effizient und reibungslos wie der menschliche Körper. Ein Industrie-PC mit der TwinCAT Runtime liefere dabei das Denkvermögen, TwinCAT Motion Control sorge für präzise, dynamische Bewegungen, vielfältigste Schnittstellen zu Sensorik und Bussystemen würden Informationen liefern, und mit TwinCAT Vision käme auch Sehfähigkeit als vollintegrierte Komponente hinzu. Mit dem neuen Softwaremodul TwinCAT Speech würden nun die Funktionen Hören und Sprechen die Analogie zu den menschlichen Fähigkeiten komplettieren, so ein Sprecher des Unternehmens.

Die Lösung ermögliche industriegerecht umgesetzt eine mehrsprachige Ein- und Ausgabe von Anfragen beziehungsweise Informationen. Damit lasse sich die Interaktion mit dem Automatisierungssystem deutlich effizienter und komfortabler gestalten, und zwar branchenübergreifend in vielfältigsten Anwendungen vom Maschinenbau bis hin zur Gebäudeautomation. So könne etwa das Bedien- oder Wartungspersonal bei Arbeiten an einer Maschinenkomponente auch ohne herkömmliches Bedienterminal einfach erfragen, wie sich geänderte Einstellungen auf das aktuelle Steuerungs- oder Simulationsprogramm auswirken, verspricht der Anbieter. Zudem könnten beim Erreichen kritischer Werte an einer Anlage entsprechende Alarmmeldungen akustisch ausgegeben werden.

Die Spracheingabe sei als eine über Build-in-Funktionalitäten des Betriebssystems Windows realisierte Offlinefunktion, also ohne Internet- und Cloudanbindung, verfügbar. Die Sprachausgabe von TwinCAT Speech sei sowohl als Offlinefunktion wie auch als Onlinefunktion verfügbar. Im ersten Fall werde dies durch die entsprechenden Funktionalitäten von Windows und im zweiten Fall durch den Text-zu-Sprache-Service Polly von Amazon unterstützt. Dabei werde mithilfe von Deep-Learning-Technologien eine realistisch klingende Sprachausgabe synthetisiert. Möglich seien zudem unterschiedliche Stimmen sowie das Caching von online generierten Audiodateien. (TM)

www.in-gmbh.de

www.idmt.fraunhofer.de

www.beckhoff.at